Website von R. Harald Baayen

Professor für Quantitative Linguistik

ERC-SUBLIMINAL Projekt, DFG-Cwic Projekt

Forschung

Ich bin an Wörtern interessiert: an ihren inneren Strukturen, ihren Bedeutungen, ihren Verteilungseigenschaften, wie sie in verschiedenen Sprachgemeinschaften und Auflistungen verwendet werden und wie sie in dem Sprachverständnis und der Sprachproduktion verarbeitet werden. Die vier Schwerpunkte meiner Forschung sind:

Morphologische Produktivität

Die Anzahl der Wörter, die durch Kompositionsregeln beschrieben werden können, variieren erheblich. Zum Beispiel ist die Anzahl der Wörter, die in einem Suffix -th (z.B.: warmth) im Englischen enden, eher gering, wohingegen es tausende Wörter gibt, die in einem Suffix -ness (z.B.: goodness) enden. Der Begriff “morphologische Produktivität” wird gewöhnlich informell benutzt, um sich auf die Anzahl der Wörter im Gebrauch in einer Sprachgemeinschaft, die von einer Regel beschrieben wird, zu beziehen.

Für ein richtiges Verständnis des faszinierenden Phänomens der morpholo- gischen Produktivität, denke ich, dass es unerlässlich ist zwischen (a) sprachinternen, strukturellen Faktoren, (b) Verarbeitungsfaktoren und (c) sozialen und stilistischen Faktoren zu unterscheiden. (Für einen kurzen Rückblick können Sie meinen Beitrag zu dem HSK-Handbuch der Korpuslinguistik als (pdf-Datei) ansehen). Formale Linguisten sind dazu geneigt, sich auf (a) zu fokussieren, während sich Psychologen auf (b) konzentrieren. Weder die Linguisten, noch die Psychologen denken gerne über (c) nach. Soziologen und Anthropologen wären womöglich nur an (c) interessiert.

Um die eher schwammige Vorstellung der Quantität, die ein Teil des Konzepts der morphologischen Produktivität ist, zu verdeutlichen, habe ich mehrere quantitative Maße, die auf bedingten Wahrscheinlichkeiten beruhen, entwickelt, um die Produktivität zu berechnen (Baayen 1992, 1993, Yearbook of Morphology).Diese Maße bemessen das Resultat der drei oben genannten Faktoren und liefern einen objektiven Ausgangspunkt zur Interpretation der Art von Daten, die von den Korpora, aus denen die Maße berechnet wurden, abgedeckt werden.

In dem Paper von 1996, zusammen mit Co-Authorin Antoinette Renouf (pdf), veranschaulichen wir, wie diese Produktivitätsmaße Licht auf die Rolle der strukturellen Faktoren werfen. Hay (2003, Causes and Consequences of Word Structure, Routledge) dokumentierte die Wichtigkeit der phonologischen Verarbeitungsfaktoren, welche für große Stichproben von englischen Affixen in Hay und Baayen (2002, Yearbook of Morphology, (pdf) als auch in Hay und Baayen(2003) in dem italienischen Journal der Linguistik (pdf) behandelt werden.

Soziale und stilistische Faktoren scheinen mindestens von gleicher Bedeutung zu sein, wie die strukturellen Faktoren, die die Produktivität erfassen, siehe z.B. Baayen 1994 in dem Journal für quantitative Linguistics (pdf), der Studie von Plag et al. (1999) in English Language and Linguistics (pdf). Für die Auflistungsvarianz und Produktivität, siehe Baayen und Neijt (1997) in Linguistics (pdf).

Hay und Plag (2004, Natural Language and Linguistic Theory) präsentierten Hinweise darauf, dass die Affixanordung im Englischen durch die Verarbeitungskomplexität eingeschränkt wird. Die auf Komplexität basierende Anordnungstheorie besagt, dass, ein Affix, das schwieriger zu parsen ist, näher am Stamm auftreten sollte, als ein Affix, das leichter zu parsen ist. (Dieses Ergebnis ist ähnlich zum Produktivitätsparadoxon, das von Krott et al., 1999, veröffentlicht in Linguistics (pdf), beobachtet wurde. Laut dem Produktivitätsparadoxon sind Wörter mit weniger produktiven Affixen eher dazu fähig weitere Wordbildungen zu formen).

Vor kurzem jedoch, erfasste eine Studie eine weitere Auswahl an Affixen, zusammen mit Co-Author Ingo Plag in Language 2009 (pdf) veröffentlicht, und belegte eine umgekehrte U-förgmige funktionale Relation zwischen der Suffixordnung und den Verarbeitungskosten bei der visuellen lexikalischen Verfügung und Wortbenennungsaufgabe. Wörter mit den niedrigsten produktiven Suffixen zeigten im Durchschnitt die kürzesten Latenzen, während Wörter mit dazwischenliegender Produktivität die längsten Latenzen aufwiesen. Die produktivsten Suffixe zeigten einen kleinen Vorteil in der Verarbeitung im Vergleich zu zwischengelagerten produktiven Suffixen. Dieses Ergebnismuster zeigt womöglich eine Wechselbeziehung zwischen der Abspeicherung und der Berechnung. Dabei wird der Rechenaufwand den Abspeicherungsaufwand nur für die produktivsten Suffixe überschreiben.

Hinsichtlich der Graphentheorie, hält die auf Komplexität basierende Ordnungstheorie daran fest, dass der gerichtete Graph englischer Suffixe azyklisch ist.habe ich gezeigt, dass die Reihenfolge von Konstituenten für zweikonstituentisch englischer Bindungen (Komposita) ebenfalls größtenteils azyklisch ist. Die Anzahl der Verstöße ist hierbei ähnlich hoch, wie bei den Affixen. Die Rangordnung für Komposita taugt jedoch nicht für die Vorhersage für lexikalische Verarbeitungskosten. Dies weist darauf hin, dass Azyklizität nicht unbedingt das Ergebnis für die auf Komplexität basierende Bedingungen sein muss. Als besonders wichtig für die Vorhersage von Verarbeitungskosten in dieser Studie erschienen die graph-theoretischen Konzepte, wie die Zugehörigkeit der stark vernetzen Komposita des Komposita-Graphen und die kürzeste Wegstrecke vom Kopf zu dem Modifizierer.

Morphologische Verarbeitung

Wie verstehen und produzieren wir morphologisch komplexe Wörter, wie hands und boathouse?Die klassische Antwort auf diese Frage ist, dass wir einfache morphologische Regeln, wie zum Beispiel eine Regel, die ein s hinzufügt, um einen Plural zu bilden oder die Regel, die es den Sprechern erlaubt Komposita von Nomen zu erstellen. Ich war mit dieser Antwort immer unzufrieden, da alles, was die Sprache zu so einem wunderbaren Gefährt für Literatur und Poesie macht, die Präsenz all der subtilen (und manchmal nicht so subtilen) Irregularitäten ist. Oftmals bringt eine ,Regel‘ einen Haupttrend in einem Feld auf, in welchem mehrere wahrscheinlichkeitstheoretische Kräfte beteiligt sind. Des Weiteren wirft das Berufen auf Regeln die Frage, wie diese angenommenen Regeln funktionieren, wie sie gelernt werden und wie sie im Gehirn umgesetzt werden.

Nichtsdestotrotz genießen morphologische Regeln enorme Beliebtheit in der formalen Linguistik. Diese neigen dazu, das Lexikon als einen Speicher für das nicht Vorhersagbare zu sehen. Die beherrschende Metapher ist die eines Lexikons als Kalkül, ein Set von elementaren Symbolen und Regeln, um diese Symbole in wohlgeformte Ausdrücke zusammenzufügen. Das Lexikon wäre dann einem Taschenrechner sehr ähnlich. So, wie ein Rechner Ausdrücke, wie 3+5 (ergibt 8) errechnet, würde eine morphologische Regel hands als den Plural von hand bestimmen. Außerdem ist es so, dass ein Rechner nicht das Ergebnis von 3+5 im Gedächtnis hat, egal wie oft wir ihn 3+5 errechnen lassen. Das mentale Lexikon (die Struktur im Gehirn, die das Gedächtnis von Wörtern und Regeln darstellt) würde keine Gedächtnisspur für das Wort handshaben. Unabhängig von der Tatsache, wie oft wir auf das Wort hand. treffen, würden wir vergessen die Pluralform gesehen, gehört oder gesagt zu haben. Alles was wir erinnern würden wäre, dass wir das Worthand benutzt haben.

Das Problem an dieser Theorie ist, dass die Häufigkeit mit der man ein Wort in Sprache und Schrift antrifft, die feinen akustischen Details mitbestimmt, mit denen sie ausgesprochen werden, als auch wie schnell wir das Wort verstehen können. Zum Beispiel veröffentlichten Baayen, Dijkstra und Schreuder eine Studie in dem Journal of Memory and Language in 1997 (pdf) in der sie zeigten, dass häufige Pluralformen, wie hands schneller gelesen werden, als seltene Pluralformen, wie noses. Baayen, McQueen, Dijkstra, and Schreuder, 2003 (pdf) berichteten später von den selben Ergebnismustern für auditorische Wahrnehmung. Weitere Diskussionen dieses Themas können in einem Kapitel eines Buches von Rob Schreuder, Nivja de Jong und Andrea Krott von 2002 (pdf)nachgelesen werden. Sogar für die Sprachproduktion gibt es Belege, dass die Häufigkeiten mit denen Singulare und Plurale benutzt werden, die Geschwindigkeit, mit der wir Nomen aussprechen (Baayen, Levelt, Schreuder, Ernestus, 2008, (pdf)), mitbestimmen.

In neueren Studien, welche die Eye-Tracking benutzen, war zunächst die Fixierungsdauer kürzer für häufigere Komposita, obgleich das gesamte Kompositum noch nicht visuell gefasst wurde (siehe Kuperman, Schreuder, Betram und Baayen, JEP:HPP, 2009 für Englisch (pdf) , und Miwa, Libben, Dijkstra and Baayen (eingereicht, erhältlich nach Anfrage) für Japanisch). Diese frühzeitigen ganzwörtigen Häufigkeitseffekte sind nicht vereinbar mit den Taschenrechner-Theorien, genauso wenig, wie mit irgendwelchen Theorien, die besagen, dass das Lesen auf anfängliche Auflösungen des visuellen Inputs in seinen Konstituenten angewiesen ist.

Die lexikalische Erinnerung erweist sich als äußerst empfindlich gegenüber den feinen Details des akustischen Signals und den Wahrscheinlichkeitsverteilungen dieser Details, siehe z.B. Kemps, Ernestus, Schreuder, and Baayen, Memory and Cognition, 2005 (pdf). Die Arbeit von Mark Pluymaekers, Mirjam Ernestus, and Victor Kuperman im Journal of the Acoustical Society of America ((pdf) and (pdf)) zeigt des weiteren, dass das Maß an Affixreduktion und die Assimilation in komplexen Wörtern mit der Häufigkeit des Gebrauchs korreliert. Offensichtlich bestimmt die genaue Häufigkeit eines Wortes die feinen Datails ihrer phonetischen Durchführung mi.

Zusammenfassend ist festzustellen, dass der übertragende Ausdruck des Gehirns, das im Grunde wie ein Taschenrechner arbeitet, nicht sehr attraktiv im Licht dessen, was wir nun über die Empfindlichkeit unseres Gedächtnisses bezogen auf die Häufigkeit des Gebrauchs und bezogen auf die phonetischen Details eines einzelnen Wortes wissen, auch wenn sie vollständig regelmäßig sind.

Wenn man weiß, dass unser Gehirn ein detailiertes Gedächtnis von regelmäßig komplexen Wörtern hat, scheint es vielversprechend das mentale Lexikon als eine große Instanzgrundlage von Formen zu sehen, die als Exemplare für analogische Verallgemeinerungen dienen. Paare wie hand/hands, dot/dots und pen/penslassen erschließen, dass der Plural von cup cups sein muss. Exemplartheorien vermuten üblicherweise, dass die Gedächtniskapazität des Gehirns so enorm ist, dass einzelne Formen im Gedächtnis gespeichert werden, auch wenn sie regelmäßig sind. Deshalb können Exemplartheorien leicht die Tatsache aufnehmen, dass regelmäßige komplexe Wörter spezielle akustische Eigenschaften haben können und dass ihre Auftrittshäufigkeit lexikalische Verarbeitungen mitbestimmen. Sie bieten ebenfalls den Vorteil leicht am Rechner implementiert werden zu können. In anderen Worten, in exemplarbasierten Einstellungen zum Lexikon wird das Lexikon als höchst Redundant angesehen, ein ausgezeichnetes Speichersystem, in welchem ’analogische Regeln’, möglicherweise sehr lokal, Verallgemeinerungen über die gespeicherten Exemplare werden. Analogie (ein Wort, das von Linguisten verabscheut wird, die an rechnungsgleiche Regeln glauben) kann durch die Verwendung von gut evaluierten Techniken in der Statistik und im maschinellen Lernen formalisiert werden. Techniken, die ich als besonders aufschlussreich und nützlich erachte, sind die so genannten Royal Skousen’s Analogical Modeling of Language (AML) und die Tilburg Memory Based Learner TiMBL die von Walter Daeleman und Antal van den Bosch entwickelt wurden.

Diese statistischen und maschinellen Lernverfahren zeigten sich als sehr nützlich für Phänomene, welche sich der Beschreibung durch Regeln entziehen, wobei Muttersprachler trotzdem sehr klare Intuitionen darüber haben, was die passenden Formen sind. Krott, Schreuder und Baayen (Linguistics, 1999, (pdf)) benutzten den Algorithmus, der am nächsten an TiMBL lag, um das Rätsel um die niederländischen Interfixe zu lösen. Ernestus und Baayen untersuchten einige Algorithmen, um die feinen wahrscheinlichkeitstheoretischen Aspekte der Phänomene von niederländischen Auslautverhärtungen ((pdf) und (pdf) zu verstehen.). Ingo Plag und seine Kollegen benutzen TiMBL, um Details über den Platz der Betonung im Englischen (siehe Plag et al. in Corpus Linguistics and Linguistic Theory 2007 und in Language, 2008) zu klären.

Speziell für Komposita, trat in kohärentes Muster hervor, wie möglicherweise die wahrscheinlichkeitstheoretischen Regeln in Sprachen wie Englisch und Niederländisch funktionieren könnten. Für die Betonung von Komposita, Interfixe und, wie Cristina Gagne zeigte, , der Interpretation von semantischen Zusammenhängen zwischen Modifizierer und dem Kopf in einem Kompositum (siehe Gagne und Shoben, JEP:LMC 1997 und ihre nachfolgende Arbeit) ist die Wahrscheinlichkeitsverteilung der möglichen Auswahlen, gegeben durch den Modifizierer, der Hauptfaktor zur Vorhersage.

Die Wichtigkeit der Wortkonstituenten als ein Gebiet der Wahrscheinlich-keitsverallgemeinerung schließt an die Ergebnisse, die durch den morphologischen Größeneinfluss einer Familie erlangt wurden, an. Einfache Wörter, die als Konstituenten in vielen anderen Wörtern (im Englischen Wörter wie ’mind’, ’eye’, ’fire’) auftauchen, werden schneller in Leseaufgaben beantwortet, als Wörter, die nur in ein paar anderen Wörtern (wie scythe, balm) auftauchen. Dieser Effekt, der zunächst nur im Niederländischen ((pdf), (pdf), (pdf)) beobachtet wurde, wurde für das Englische und typologisch nicht verbundenen Sprachen, wie Hebräisch und Finnisch ((pdf), (pdf)) wiederholt. Wörter mit paradigmatischen Zusammenhängen zu anderen Wörtern werden schneller verarbeitet, wohingegen diese anderen Wörter Exemplarsets darstellen, die die analogische Verallgemeinerung informieren.

Obwohl exemplarbasierende Einstellungen zu der lexikalischen Verarbeitung computational attraktiv sind, weisen sie ihre eigenen Probleme auf. Eine Frage betrifft die Redundanz, welche durch das Speichern von vielen sehr ähnlichen Exemplaren in Erscheinung tritt. Eine weitere Frage bezieht sich auf die enorme Anzahl von Exemplaren, die womöglich gespeichert werden müssen. Hinsichtlich der ersten Frage ist es erwähnenswert, dass jedes arbeitsfähige und arbeitende exemplarbasierte System, wie das TiMBL, einen Speicheralgorithmus implementiert, um das Problem, ein bestimmtes Exemplar in einer sehr großen Instanzbasis von Exemplaren nachzuschauen, zu erleichtern. In anderen Worten, Ansätzen, die maschinelles Lernen benutzen werden um eine Art von Datenkompression nicht herumkommen.

Die zweite Frage ist weitaus schwieriger abzutun. Bis vor kurzem habe ich noch geglaubt, dass die Anzahl verschiedener Wortformen in Sprachen wie Niederländisch und Englisch so gering ist, für einen gebildeten Erwachsenen im Durchschnitt, der Muttersprachler ist, macht das etwas unter 100.000, dass die enorme Speicherkapazität des menschlichen Gehirns solch eine Anzahl von Exemplaren ohne Probleme fassen können sollte. Kürzlich wurde jedoch von einigen Gruppen Häufigkeitswirkungen für Sequenzen von Wörtern berichtet. Beispielsweise untersuchte Antoine Tremblay Sequenzen von vier Wörtern die direkt wiedergegeben werden sollten, wobei sie Häufigkeitswirkungen in dem hervorgerufenen Antwortspotential, das an der Kopfhaut gemessen wurde (pdf) beobachtete. Entscheidend ist, dass diese Häufigkeitswirkungen (mit Häufigkeitswirkungen für Teilfolgen von Wörtern, die kontrolliert wurden) nicht nur für vollständige Phrasen (wie on the large table) entstanden, sondern auch für Teilphrasen (wie the president of the). Es gibt enorm viele verschiedene Sequenzen von Wortpaaren, Tripple, Quartett, usw. Es ist möglich, dass das Gehirn all diese Milliarden von Exemplaren speichert, was ich jedoch als unwahrscheinlich erachte. Dieses Problem der exponentiellen Explosion von Exemplaren taucht nicht nur bei dem Wechsel von der Wortbildung zur Syntax auf, sondern auch, wenn wir in den auditiven Bereich wechseln und die akustischen Exemplare von Wörtern betrachten. Ein Sprecher wird niemals ein Wort auf ein und dieselbe Weise zweimal sagen. Wenn man Exemplare für die akustischen Exemplare von Wörtern annimmt, läuft dies wieder auf eine riesige Anzahl an Exemplaren hinaus die im Gedächtnis gespeichert sein müssten (siehe, z.B., Ernestus and Baayen (2011) (pdf) für eine Diskussion des Themas).

Es gibt einige Alternativen zur Exemplartheorie. Die erste Möglichkeit wäre, die klassische Position in der generativen Linguistik zu verfolgen und abstrakte Regeln von der Erfahrung abzuleiten, wodurch man keiner individuellen Exemplare bedarf. Wohingegen Exemplarmodelle, wie das TiMBL, als „lazy learning“ charakterisiert werden können, mit analogischem Verallgemeinerungsbetrieb während der Laufzeit über eine Instanzbasis von Exeplaren, ist „greedy leraning“ charakteristisch für Regelsysteme wie der Minimum Generalization Learner (MGL) von Albright und Hayes (Cognition, 2003), welches große Sets von komplexen symbolischen Regeln von dem Input ableitet. Solche Systeme sind sehr sparsam mit Datenspeicher. Dieses Vorgehen hat jedoch seinen Preis. Erstens finde ich die Komplexität des abgeleiteten Regelsystems unattraktiv aus der kognitiven Perspektive. Zweitens, wenn das System einmal trainiert ist, funktioniert es, aber es kann nichts mehr hinzulernen: es endet damit, dass das System wie ein fortgeschrittener Taschenrechner funktioniert. Drittens werden Häufigkeiten und Größeneinflüssen von Familien für (regelmäßige) komplexe Wörter nicht hierdurch erklärt. Interessanterweise hebt Emmanuel Keuleers in seiner Antwerpen 2008 Doktordissertation hervor, dass aus der Perspektive der Berechnung das MGL und das exemplarbasierte Modell der nächsten Nachbarn gleichwertig sind. Der Hauptunterschied liegt in dem Punkt, an dem die Exemplare evaluiert werden (während der Lernphase für das MGL, wahrend der Laufzeit des Exemplarmodells).

Eine weitere Alternative wäre das Konnektionistische Modell. Künstlich erzeugte neuronale Netzwerke (ANNs, siehe, z.B., the seminal study of Rumelhart and McClelland, 1986) bieten viele Vorteile. Diese Netzwerke sind starke statistische Musterassoziierer. Diese führen eine Art von Datenkompression durch. Außerdem können diese für das Zusammenstellen von Sprachdefiziten verletzt werden. Des Weiteren sind sie nicht auf einen bestimmten Input beschränkt. Andererseits ist es nicht klar, zu welchem Ausmaß aktuelle Konnektionistische Modelle symbolische Aspekte der Sprache (siehe, Levelt, 1991, Sprache und Kognition) hand- haben kann. Des Weiteren ist die Performanz der ANN oftmals nicht direkt interpretierbar. Auch wenn die Metaphor der neuronalen Netzwerke ansprechend ist, machen die Konnektionistische Modelle, die mir bekannt sind, Gebrauch von Trainingsalgorithmen, die mathematisch anspruchsvoll aber biologisch nicht plausibel sind. Nichtsdestotrotz bieten Konnektionistische Modelle überraschend gute Passung von Beobachtungsdaten in lexikalischen Prozessen. Ich hatte das Vergnügen mit Fermin Moscoso del Prado Martin für mehrere Jahre zusammenzuarbeiten. Seine Konnektionistische Modelle (siehe (pdf) und (pdf)) behandeln Häufigkeitseffekte, der Größeneinfluss einer Familie, als auch wichtige linguistische Verallgemeinerungen.

Vor kurzem habe ich, in Zusammenarbeit mit Peter Milin, Peter Hendrix und Marco Marelli, einen Ansatz von morphologischer Verarbeitung, die auf Unterscheidungslernen (definiert von den Rescorla-Wagner Gleichungen) basiert, entdeckt. Diese Gleichungen bestimmen, wie sich die Stärke eines Hinweises hin zu einem gegebenen Resultat mit der Zeit verändert. Dabei ist wichtig, wie gültig der Hinweis für ein bestimmtes Resultat ist. Ramscar, Yarlett, Dye, Denny und Thorpe (2010, Cognitive Science) zeigten, dass die Rescorla-Wagner Gleichungen großartige Vorhersagen über den Spracherwerb macht. Ihrem Beispiel folgend, haben wir das Potential dieser Gleichungen für die morphologische Verarbeitung untersucht. Die wesentliche Intuition ist die folgende: Scrabble-Spieler wissen, dass das Buchstabenpaar ’qa’ für das zulässige Scrabblewort ’qaid’, ’qat’ und ’qanat’ ist. Die Gültigkeit des Hinweises von ’qa’ für diese Wörter ist ziemlich hoch, wohingegen die Gültigkeit des Hinweises für den Buchstaben ’a’ für die genannten Wörter ziemlich gering ist - es gibt viel häufigere Wörter, die ein ’a’ beinhalten (apple, a, and, can, ...). Kann es also sein, dass viele dieser morphologischen Effekte in der lexikalischen Verarbeitung wegen der Hinweisstärke der orthographischen Informationen (geliefert durch die Buchstaben und Buchstabenpaare) zur Wortbedeutung erscheinen?

Um dieser Frage auf den Grund zu gehen, benutzen wir die Gleichgewichtsgleichungen, die von Danks (Journal of Mathematical Psychology, 2003) entwickelt wurden. Diese Gleichungen ermöglichen es die Gewichtung der Hinweise (Buchstaben(paare)) hin zu den Resultaten (Wortbedeutung) von Kookkurenz Matrizen aus Korpora zu berechnen. In unserem Fall wären dies Kookkurenz Matrizen von 11,172,554 zwei- und dreiwörtige Phrasen (umfasst in allem 26,441,155 Worttoken) aus dem British National Corpus abgeleitet. Die Aktivierung einer Bedeutung wurde durch das Summieren der Gewichte der aktiven Buchstaben und Buchstabenpaare in ihrer Bedeutung erhalten. Antwortlatenzen wurden als spiegelbildlich proportional zu der Aktivierung modelliert. Zudem wurden sie log-transformiert, um den Schräglauf der daraus resultieren- den Aufteilung von simultierten Reaktionszeiten für eine statistische Analyse zu entfernen. Wir bezeichnen das Modell als Naive Discriminative Reader, wobei ’naiv’ sich auf die Tatsache bezieht, dass die Gewichtung eines gegebenen Resultats unabhängig von der Gewichtung anderer Resultate bewertet wird. Das Modell ist naiv in Bayes naiver Bedeutung.

Es stellte sich heraus, dass diese sehr einfache, a-morphete Architektur einen großen Bereich der Effekte, die für die lexikalische Verarbeitung dokumentiert wurden, abdeckt. Dies beinhaltet auch die Häufigkeitseffekte, den morphologischen Größeneinfluss einer Familie und die relativen Entropie-Effekte. Für monomorphemische Wörter bietet der Naive Discriminative Reader eine großartige Vorhersage ohne irgendwelche freie Parameter zu benötigen. Für morphologisch komplexe Wörter benötigt man für eine akkurate Vorhersage ein paar freie Parameter. Zum Beispiel zeigt sich, dass die Bedeutung von Kopf- Nomen weniger wichtig ist, als die Bedeutung des Modifizierers (welche zuerst gelesen wird). Das Modell erfasst Häufigkeitseffekte für komplexe Wörter, ohne einer Verkörperung von komplexen Wörtern in dem Modell. Das Modell sagt ebenfalls phrasale Häufigkeitseffekte (Baayen und Hendrix, 201) voher (pdf); wieder ohne Phrasen, die ihre eigene Verkörperung in dem Modell erhalten. Das Modell arbeitet so gut wie ein generalisiertes lineares Mixed-Effect-Modell und eine Support-Vektor-Maschine (pdf) , wenn das Modell als Klassifizierer für die Vorhersage von einem Dativwechsel benutzt wird.

Das Naive-Discriminative-Reader-Modell unterscheidet sich sowohl von dem subsymbolischen Modellen als auch von den IAC Modellen. Das Modell gehört nicht zu der Klasse der subsymbolischen Modelle, da die Repräsentationen von Buchstaben, Buchstabenpaare und Bedeutung alle direkte symbolische Repräsentationen sind. Es gibt keine versteckten Ebenen, genauso wenig, wie die Rückwärtspropagierung. Zudem ist es kein IAC Modell, da es nur einen Vorwärtspfad von Aktivierung gibt. Des Weiteren werden die Gewichtungen nicht per Hand gesetzt, sondern werden durch den Input des Korpus erlangt. Zusätzlich geht es extrem sparsam mit der Anzahl von Repräsentationen, die benötigt werden, um. Dies gilt vor allem für den Vergleich mit dem interaktiven Aktivierungsmodell, welches Repräsentationen für n-Gramme miteinbezieht. Die Ergebnisse, die wir bisher mit diesem neuen Vorgehen erhalten haben, erscheinen viel versprechend. Gemäß unseres Wissens gibt es keine anderen implementierten Rechenmodelle für die morphologische Verarbeitung, die die Menge an morphologischen Phänomene richtig vorhersagen, die vom Naive Discriminative Reader gut abgedeckt werden. Es wäre interessant und informativ herauszufinden, wo diese Vorhersagen versagen würden.

Sprachvariation

Mein Interesse an Stilometrie wurde durch die bahnbrechende Arbeit von John Burrows entfachtet, welcher stilistische, regionale und auktoriale Unterschiede anhand von Hauptkomponentenanalysen dokumentierte, welche auf die relative Häufigkeit von der höchsten Häufigkeitsfunktion von Wörtern in literarischen Texten angewendet wurden. Burrows Forschung inspirierte eine Studie die im Journal of Quantitative Linguistics mit dem Titel ‘Derivational Productivity and Text Typology’ (pdf), veröffentlicht wurde, welche das Potential eines Produktivitätsmaßes untersuchte, um verschieden Texttypen zu unterscheiden. Baayen, Tweedie und Van Halteren (1996, Literary and Linguistic Computing) verglichen Funktionswörter mit syntaktischen Tags in einer Studie zur Autorenidentifikation. Baayen, Van Halteren, Neijt und Tweedie (2002, Proceedings JADT (pdf)) und Van Halteren, Baayen, Tweedie, Haverkort, und Neijt (JQL, 2005, (pdf) zeigten, dass in einem Kontrollexperiment das Geschriebene von acht Studenten niederländischer Sprache und Literatur der Universität von Nijmegen bis zu einem bemerkenswerten Grad richtig zugeordnet werden konnten (80% bis 95% richtige Zuordnungen). Dies wurde von Patrick Juola in dem CHUM-Paper mit dem Titel A Controlled-Corpus Experiment in Authorship Identification by Cross-Entropy (pdf) erneut analysiert. Für eine Studie über die soziostilistische Stratifizierung des niederländischen Suffixes -lijk in Sprache und Schrift, siehe Keune et al. (2006, (pdf)), und die Anwendung des gemischten Effektmodells in soziolinguistischen Studien von Sprachvariation, siehe Tagliamonte und Baayen (2011, (pdf)). Ich bin ebenfalls an individuellen Unterschieden zwischen Sprecher/Schreiber in experimentellen Aufgaben interessiert. In einer Studie, die individuelle Unterschiede zwischen dem Sprecher bezogen auf den Speicher und die Berechnung von komplexen Wörtern vorschlägt, siehe meinen Artikel, den ich mit Petar Milin (pdf) geschrieben habe. Zur Registrierungsvariation in morphologischer Leistungsfähigkeit, siehe z.B. Plag et al. (1999) (pdf) in English Language and Linguistics.

Statistische Analyse von Sprachdaten

Mein Buch über die Häufigkeit von Wortverteilungen (Kluwer, 2001) gibt eine Übersicht über statistische Modelle für die Häufigkeit von Wortverteilungen. Stefan Evert entwickelte die LNRE Erweiterung des Zipf-Mandelbrot Modells (Evert, 2004, JADT proceedings), welches eine flexible und oftmals eine robustere Erweiterungen der Arbeit in meinem Buch bietet.

Für mich ist R ein großartiges open-source Werkzeug für die Datenanalyse. Mein Buch, Analyzing Linguistic Data: A practical introduction to Statistics using R (Cambridge University Press) bietet eine Einführung in R für Linguisten und Psycholinguisten. Eine ältere Version dieses Buches, mit verschiedenen (Schreib)fehlern, ist auf diesen Seiten zu finden (siehe meine Liste von Publikationen im Link). Die in dem Textbook benutzten Daten und den passenden Funktionen gibt es in dem languageR-Package, erhältlich im CRAN Archiv. Aktuelle Versionen dieses Packages besitzen ein paar weitere Funktionalitäten, die nicht in meinem Buch dokumentiert werden, wie zum Beispiel eine Funktion, um Teileffekte von Mixed-Effects-Regression-Modellen darzustellen (plotLMER.fnc ), sowie eine Funktion, um eine Autokorrelationsstruktur in psychologischen Expe- rimenten (acf.fnc) zu untersuchen.

Mixed-Effects-Modelle sind eine tolle Technik, um die Struktur von Daten zu verstehen, die fixe und zufällig verteilte Effekte beinhaltet, wie sie typischer weise in (psycho)linguistischen Experimenten vorkommen. Meine Lieblingsreferenz für verschachtelte zufällig verteilte Effekte ist Pinheiro und Bates (2000, Springer). Für Daten, mit fixen und zufällig verteilten Effekte, gibt es das lme4-Package von Douglas Bates, welches einen flexiblen Werkzeugsatz für R bietet. Ein Artikel, geschrieben mit Doug Davidson und Douglas Bates in JML, Mixed-effects modeling with crossed random effects for subjects and items (pdf) und das siebte Kapitel meines Einführungstextbooks bieten eine ganze Menge von Beispielen ihrer Anwendung. Ein sehr empfehlenswertes, etwas technischeres Buch über Mixed-Effect-Modelle, ist Julian J. Faraway (2006) Extending Linear Models with R: Generalized Linear, Mixed Effects and Nonparametric Regression Models, Chapman and Hall. Praktische Studien, die die methodologischen Aspekte von Mixed-Effects-Modellen diskutieren, an denen ich beteiligt war, sind Capturing Correlational Structure in Russian Paradigms: a Case Study in Logistic Mixed-Effects Modeling (mit Laura Janda und Tore Nesset) (pdf) ,Analyzing Reaction Times (mit Petar Milin) (pdf), Models, Forests and Trees of York English: Was/Were Variation as a Case Study for Statistical Practice, mit Sali Tagliamonte (pdf), und Corpus Linguistics and Naive Discriminative Learning (pdf). Ein methodologischer Artikel (pdf) illustriert mit Hilfe von Simulationsstudien die Nachteile des Gebrauchs von faktoriellem Design, welche bei Psycholinguisten immer noch sehr geliebt sind, für Studien bei denen ein Design mit Regressionen angebrachter wäre.

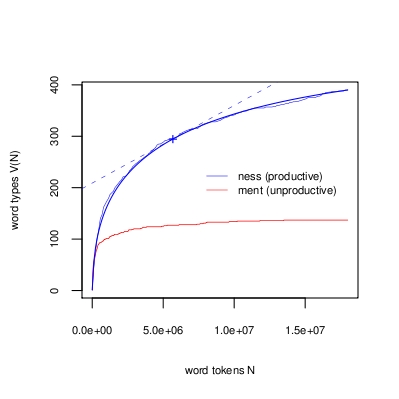

Die Wahrscheinlichkeit einen neuen, zuvor nicht gesehenen Worttypen in einem Text anzutreffen, nachdem man N Worttoken gelesen hat, wird durch den Anstieg der Tangente in der Kurve am Punkt (N, V(N)) beschrieben. Dieser Anstieg (ein Ergebnis des Turing) ist dieselbe Zahl, wie die Anzahl der Worttypen, die genau einmal in den ersten N Token auftauchen geteilt durch N. Die Kurven zeigen in der obigen Abbildung, wie die Anzahl verschiedener Wörter, die in ness enden, stetig ansteigen, während man durch einen 18Millionen großen Wortkorpus liest. Die Anzahl der verschiedenen Wörter, die in ment enden, erreicht schnell eine horizontale Asymptote, was zeigt, dass die Wahrscheinlichkeit der Wahrung neuer Formationen mit diesem Suffix Null ergibt. Baayen (1992) gibt einen detaillierten Einblick in dieses Vorgehen, um Produktivität zu messen.

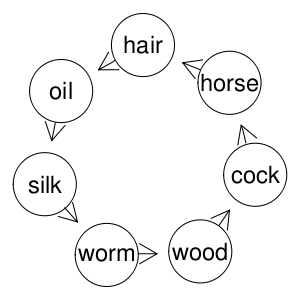

Ein Kreis in dem englischen Komposita-Graphen: (woodcock, cockhorse, horsehair, hair oil, oil-silk, silkworm, wormwood). Jeder Modifizierer ist auch ein Kopf, wie auch jeder Kopf ein Modifizierer ist.

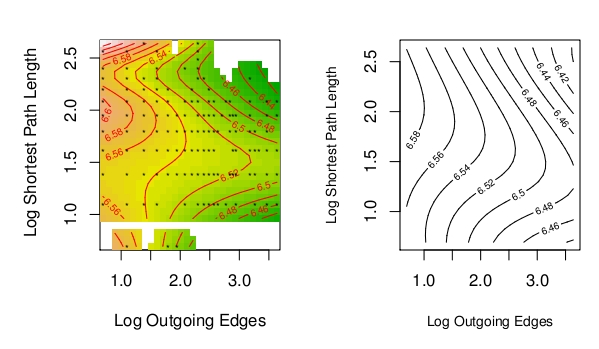

Die Kostenoberfläche für das Vorlesen von Komposita, als eine Funktion der Anzahl von abgehenden Rändern für den Modifizierer und die kürzeste Weglänge vom Kopf zum Modifizierer. Die beobachtete Oberfläche (links) wird gut durch die theoretische Oberfläche (rechts) angenähert, welche durch die Hypothese erhalten wird, dass die Aktivierung, die vom Kopf durch das Netzwerk zum Modifizierer wandert, am meisten interferiert, wenn die Wegstrecke nicht zu lang und nicht zu kurz ist. Sehr kurze Wegstrecken (houseboat/boathouse) interferieren wegen einer festen Unterstützung durch den visuellen Input nicht, während sehr lange Wegstrecken wegen einer Aktivierungsverzögerung mit jedem Schritt durch den Kreis nicht interferieren. Weitere Details stehen in Baayen (2010)

Das Berechnen formaler Sprachen bietet keine nützliche Metapher für das Verständnis wie das Gehirn mit Wörtern befasst. Das Gehirn ist kein Taschenrechner, der sich nie an das erinnert, was er zuvor errechnet hat.

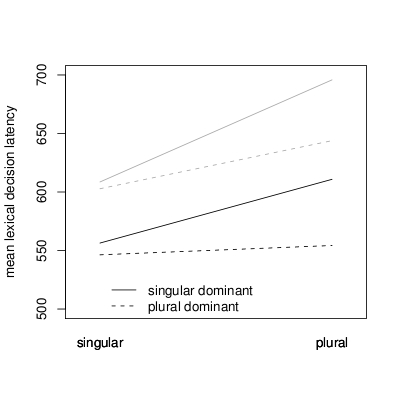

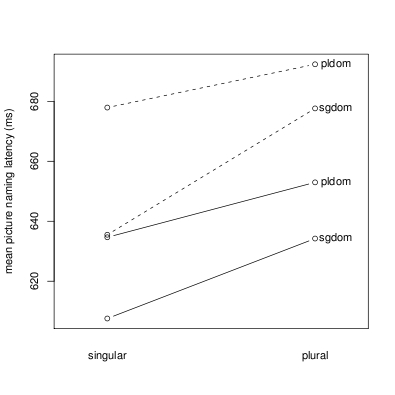

Der sogenannte Häufigkeits-Dominanz-Effekt beim Lesen und Hören (oben) unterscheidet sich von dem beim Sprechens (unten). Ein Singular dominantes Nomen ist ein Nomen, für welches der Singular häufiger ist, als der Plural (z.B. nose). Ein Plural dominantes Nomen ist durch den Plural charakterisiert, welcher häufiger vorkommt als sein Singular (z.B. hands). Sowohl im Lesen als auch Hören wird der Plural dominante Plural schneller verstanden, als ein Singular dominanter Plural, der für die Stammhäufigkeit aufgenommen wird; für sowohl häufige als auch seltene Nomen. Während des Sprechens benötigen interessanterweise sowohl der Plural als auch der Singular mehr Zeit, um ausgesprochen zu werden, wenn der Plural dominant ist. Baayen, Levelt, Schreuder, and Ernestus (2008) zeigen, dass diese Verspätung in der Produktion von der hohen Informationsverarbeitung (Entropie) des Inflektionsparadigmas der Pluraldominanz von Nomen herrührt.

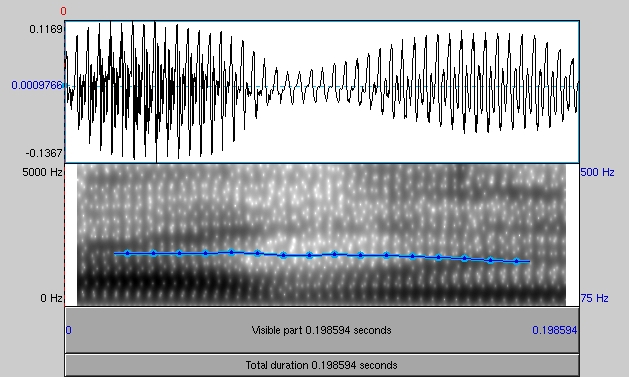

Komplexe Wörter, die häufig genutzt werden, tendieren dazu während des Sprechens zu solch einem Ausmaß beträchtlich gekürzt zu werden, dass die Wörter ohne Kontext nicht mehr erkannt werden können. Innerhalb des Kontexts rekonstruiert das Gehirn die akustischen Signale in ihrer kanonischen Form. Kemps, Ernestus, Schreuder and Baayen (2004) (pdf) zeigten diesen Wiederherstellungseffekt für niederländische Suffixwörter. Für das Englische zeigt das folgende Beispiel dieses Phänomen. Hören Sie sich bitte zunächst diese Aufnahme an, welche ein gewöhnlich häufiges englisches Wort abspielt. Wenn man sich das Wort alleine anhört, macht es keinen Sinn. Nun hören Sie sich das Wort in dieser Aufnahme an , welche auch den Kontext des Wortes abspielt. Der Satz und das reduzierte Wort werden hier genau erklärt. Ein führender Spezialist für akustische Reduktion ist Mirjam Ernestus .

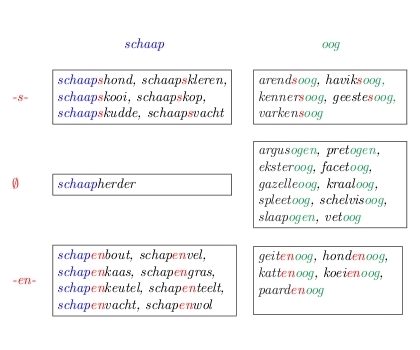

Eine Auswahl von Interfixen für das niederländische Kompositum schapenoog beruht zunächst auf die Verteilung von Interfixen in einem Set von Komposita, die sich den Modifizierer schaap teilen. Wie in dem Set dargestellt wird, ist en der Interfix, der am häufigsten bestätigt wird und der bevorzugte Interfix für dieses Kompositum ist. Siehe Krott, Schreuder and Baayen (1999) für eine weitere Diskussion. Die Aufgabe von Akzentuierung in englischen Komposita und die Interpretation der semantischen Beziehung zwischen Modifizierer und Kopf basiert auf exakt ein und demselben Prinzip: mit dem Modifizierer als dem wichtigsten Bereich der wahrscheinlichkeitstheoretisch gesteuerten Verallgemeinerung.

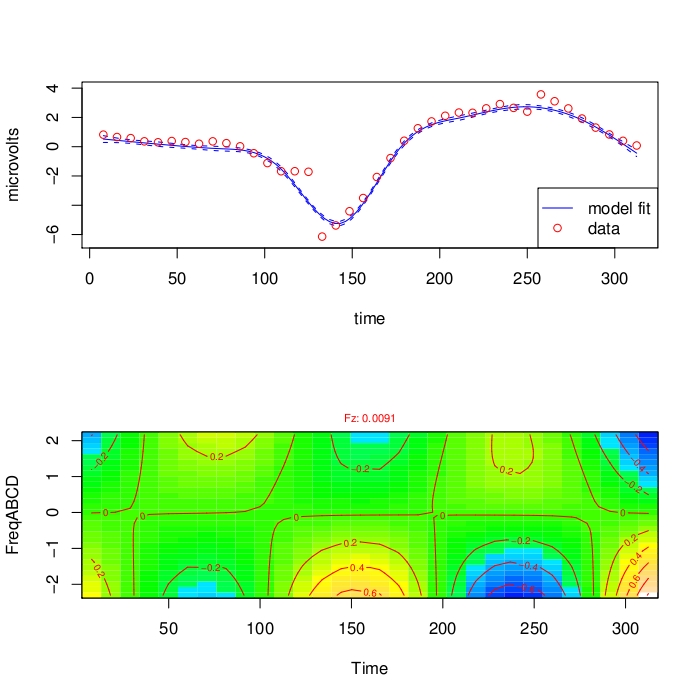

Die Häufigkeit einer Folge, die aus vier Wörtern besteht (n-Gram), passt die hervorgerufene Antwort an das Potential von 150 Millisekunden eines Post-Stimulus Anfangs in einer unmittelbaren Wiederaufruf-Aufgabe an die Elektroden Fz an. Das obere Feld zeigt den Hauptverlauf mit der Standartnegativität um 150 ms. Das untere Feld zeigt, wie dieser allgemeine Verlauf angepasst wird durch die Häufigkeit einer Phrase, die aus vier Wörtern besteht (FreqABCD auf vertikalen Achse). Für die Häufigkeit niedriger n-Gramme, sind höhere Amplituden Thetaschwingungen präsent. Tremblay and Baayen (2010) bietet weitere Details.

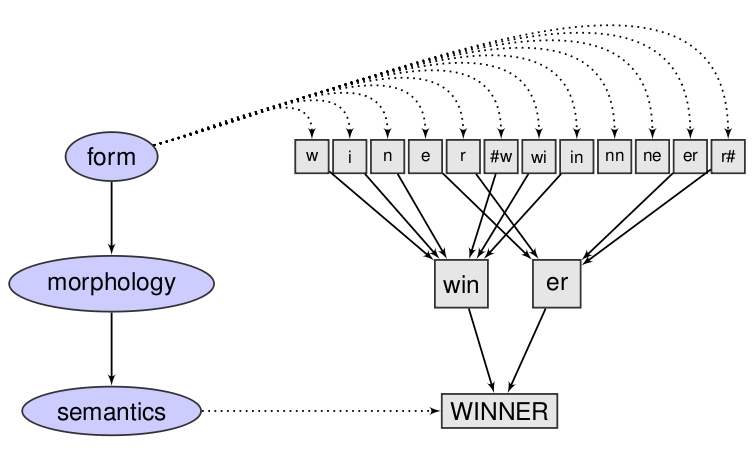

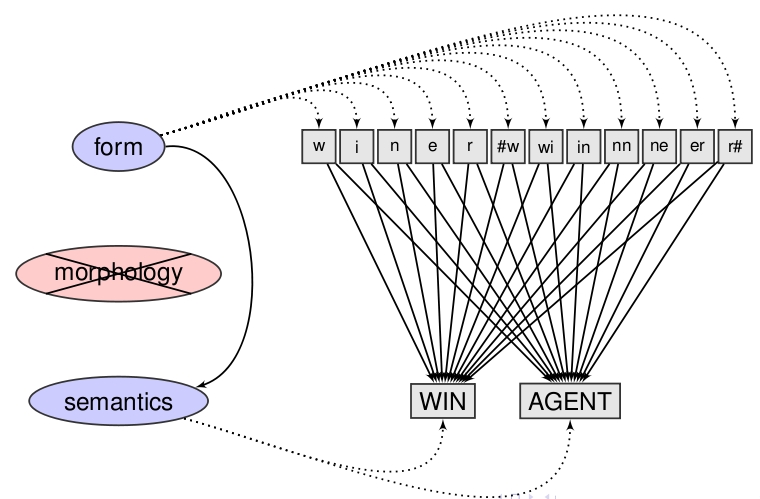

Ein bekanntes Modell über die Psychologie des Lesens ist, dass orthographische Morpheme (z.B. win und er für winner) Zugriff von dem orthographischen Level zur Wortbedeutung vermitteln. Diese Theorie wurde, soweit ich weiß, noch nie in einem Rechnungsmodell umgesetzt.

In dem Naive-Discriminative-Reader-Modell (wird in R in dem Package ndl umgesetzt) gibt es keinen getrennten morpho-orthographischen Repräsentationsabschnitt. Orthographische Darstellungen für Buchstaben und Buchstabenpaare sind direkt mit wesentlichen Bedeutungen wie WIN und AGENT verbunden. Die Gewichtung der Verbindungen wird einerseits durch die Koauftretensmatrix der Hinweise berechnet und andererseits durch die Wiedererscheinungsmatrix der Ergebnisse und Hinweise. Dafür werden die Grenzgleichgewichts-Gleichungen für die Rescorla-Wagnergleichung benutzt, die von Danks (Journal of Mathematical Psychology, 2003) entwickelt wurde. Die Schätzwerte sind optimal im Sinne der kleinsten Quadrate.

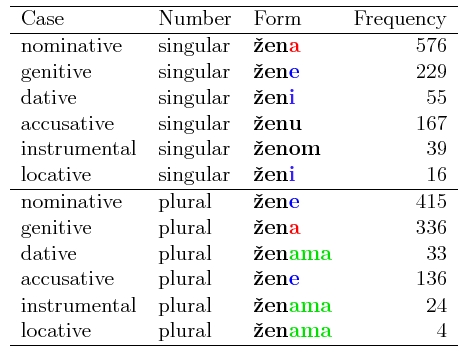

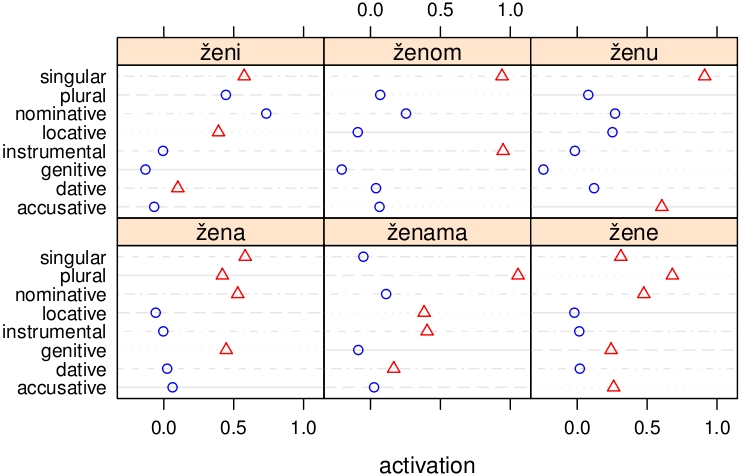

Warum keine Morpheme? Viele Morphologen (z.B. Matthews, Anderson, Blevins) argumentierten, dass Affixe keine Zeichen im Sinne Saussurians sind. Zum Beispiel repräsentiert die serbische Fallendung a in žena (Frau) entweder NOMINATIV und SINGULAR oder PLURAL und GENITIV. Normale Zeichen, wie tree können mehrere Bedeutungen haben (wie ‚'any perennial woody plant of considerable size', 'a piece of timber', 'a cross', 'gallows'). Diese verschiedenen Bedeutungsstufen sind jedoch normalerweise nicht gleichzeitig gemeint.

Die naive Unterscheidung sagt Aktivierung für alle grammatischen Bedeutungen voraus, die mit einer Fallendung verbunden werden. Diese sind abhängig von den Häufigkeiten mit welchen die Bedeutung benutzt wird, wie diese Bedeutungen der anderen Wörter in derselben Flexionsklasse (cf. Milin et al., JML, 2009) benutzt werden und ihrem Gebrauch in anderen Flexionsklassen. Die roten Dreiecke stellen die Aktivierung dar, welche durch das Naive-Discriminative-Reading-Modell für die richtige Bedeutung vorherbestimmt wird. Die blauen Kreise zeigen die Aktivierung von Bedeutungen, die falsch sind. Wie erhofft, tendieren die roten Dreiecke eher dazu recht von den blauen Kreisen zu sein, was eine höhere Aktivierung für eine richtige Bedeutung darstellt. Für ženi haben wir eine Beeinflussung der Fallendung –i, welche den Nominativ Plural in maskulinen Nomen ausdrückt.

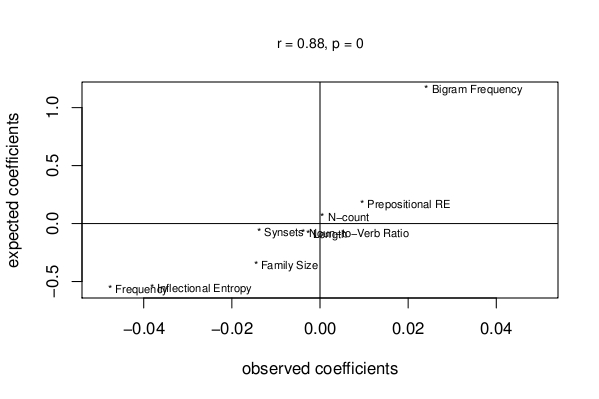

Die Koeffizienten eines Regressionsmodells, angepasst an die beobachteten Reaktionszeiten in einem visuellen lexikalischen Entscheidungsexperiments mit 1289 englischen Monomorphemischen Wörtern, korrelieren gut mit den Koeffizienten des selben Modells, welches an die simulierten Reaktionszeiten angepasst wurde, die von dem Naive-Discriminative-Reading-Modell vorhergesagt wurden. Das Modell fasst nicht nur Effekte in weitem Umfang von Prädiktoren (von links nach rechts, Worthäufigkeit, Inflektionale Entropie, Morphologische Familiengröße, Anzahl der Bedeutungen, Wortlänge, Nomen-Verb Ratio, N-Anzahl, Prepositionale relative Entropie und Buchstaben-Bigram Häufigkeit) sondern auch die relative Größe dieser Effekte.

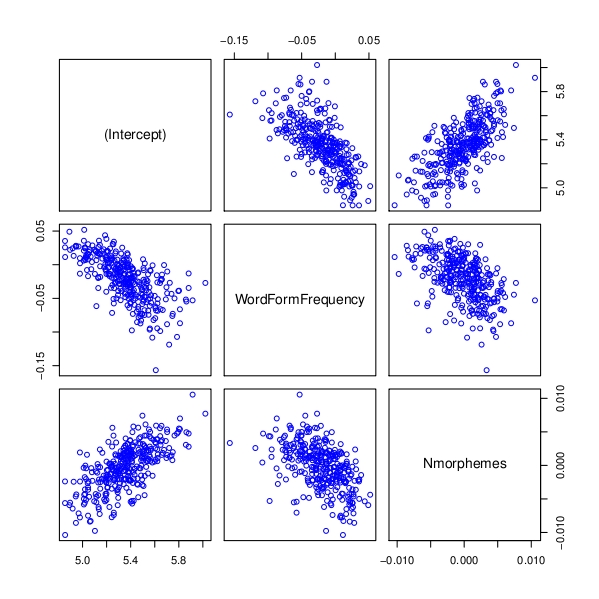

Streudiagramm-Matrix für per-Proband Achsenabschnitte und Anstiege gemäß dem Mixed-Effects-Regressionsmodells für das eigenständige Lesen niederländischer Poesie. Langsamere Leser haben größere Achsenabschnitte. Für die meisten Teilnehmer ist der Anstieg für die Wortformhäufigkeit negativ: sie lesen häufigere Wörter schneller als erwartet. Die Teilnehmer variieren darin, wie sie komplexe Wörter verarbeiten. Sie sind Probanden, die komplexe Wörter mit mehr Konstituenten langsamer lesen, während andere Wörter schneller lesen, wenn diese mehr Konstituenten beinhalten (Nmorpheme). Interessanterweise nehmen die langsamen Leser eher die Förderung von Worthäufigkeiten wahr. Andererseits verweilen die langsameren Leser länger auf einem Wort, je mehr Konstituenten es besitzt. Schneller sind Leser, die keine Förderung von Worthäufigkeiten zeigen. Innerhalb der Population unserer Informanten findet ein Austausch zwischen konstituentenunterstützer Verarbeitung und gedächtnisbasierter Ganzwörterverarbeitung statt. Die meisten Teilnehmer sind ausgeglichen. An den Extremen finden wir jedoch bestimmte Lumper und eifrige Splitterer. Weitere Details zum Experiment unter Baayen and Milin (2011).

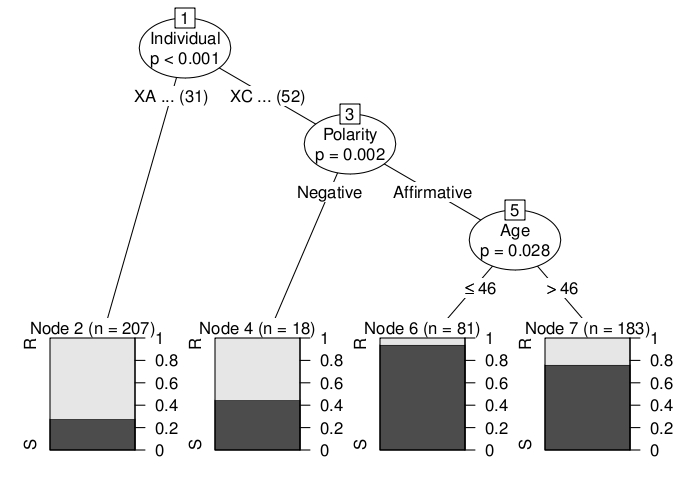

Ein bedingter Deduktionsbaum, welcher die Wahl zwischen was (S) und were (R) in einem Satz wie There wasn’t the major sort of bombings and stuff like that but there was orange men. vorhersagt. You know there em was odd things going on. Für York (UK) Englisch. Ein zufälliger Forest basiert auf bedingte Deduktionsbäume (im party package für R), welche ein Generalized-Linerar-Mixed-Modell vorhersagen und zu denselben Daten in Beziehung auf Vorhersagenexaktheit passen. Siehe Tagliamonte and Baayen (2012) für mehr Details.